Moisés Horta: « Décoloniser l’Intelligence Artificielle »

Publié le 2 octobre 2020 par la rédaction

Makery a rencontré Moisés Horta à Ars Electronica. Il y jouait sa performance live audiovisuelle, mixant anciens et nouveaux médias en une expérience multisensorielle de symbiose entre l’IA et les techniques spirituelles ancestrales pré-hispaniques. Il nous a parlé ensuite des réseaux neuronaux dans l’art visuel et sonore.

Moisés Horta Valenzuela est un artiste sonore et compositeur de musique électronique originaire de Tijuana au Mexique. Sa pratique s’inscrit dans la musique numérique et l’histoire politique des technologies. Makery a eu avec lui une intéressante conversation, après sa conférence « Artificial Stupidity » le 13 septembre dernier à Ars Electronica : musique et IA, histoire culturelle et deep fakes… Interview.

Quel est votre parcours ?

Je m’appelle Moisés Horta. Je viens de Tijuana au Mexique, mais actuellement j’habite Berlin. Je suis un musicien électronique autodidacte. Pendant plusieurs années, j’ai fait partie de la scène Ruidosón à la frontière entre le Mexique et les Etats-Unis (si vous voulez en savoir plus sur ce mouvement, il existe un livre, également disponible en PDF).

Ruidosón est un son que des amis et moi-même avons développé à partir de 2009. Nous essayions de produire un son unique qui vienne de la frontière, en réponse à l’idée de mondialisation. J’ai co-fondé le groupe Los Macuanos, dans lequel j’ai été actif pendant six ans. Nous samplions de la musique pré-hispanique, nous la retournions, pour en donner une version vraiment sombre, dans laquelle nous mettions aussi beaucoup d’intentions politiques. A cette période, Tijuana était envahie par la violence, mais nous organisions quand même des fêtes.

J’ai déménagé ensuite à Mexico City, où j’ai commencé à me concentrer plus fortement sur l’art et la technologie. J’explorais l’idée d’identité : Que veut dire identité nationale dans un contexte global ? Je critiquais l’idée de mondialisation – Quand nous parlons de mondialisation, nous parlons en fait de l’hégémonie culturelle des Etats-Unis, de l’Europe et du « Nord Global », ou au moins d’idées occidentales. Cette approche critique a toujours fait partie de mon travail. A Mexico City, j’ai commencé à faire des installations artistiques sonores.

En 2016 j’ai déménagé en Europe, où j’ai rencontré l’artiste sonore danois Goodiepal. Il composait de la musique radicale, et nous discutions beaucoup de l’Intelligence Artificielle, de manière spéculative et critique. Cela a été ma première introduction aux réseaux neuronaux, et je les ai abordé avec une forte approche critique, car j’étais très influencé par son travail. J’ai ensuite déménagé à Berlin, où j’ai continué à faire de la musique et de l’art sonore, en y incorporant toujours ma critique de la mondialisation, de l’identité, etc.

Pouvez-vous nous en dire plus sur votre projet Hexorcismos ?

Hexorcismos a grandi comme un projet parallèle. Il a débuté en 2013, lorsque j’habitais encore à Mexico City. C’est un projet musical dans lequel j’explore les relations entre la composition de musique électronique et l’art sonore, et qui me permet d’incorporer des thèmes dans la musique de manière plus abstraite. Je me suis intéressé au Sonido 13, une théorie sur la musique microtonale datant du début du XXe siècle, j’ai pensé que cette idée pouvait être poussée plus loin. Hexorcismos est un projet expérimental, qui me permet d’explorer en toute liberté, sans faire nécessairement de la musique électronique pour danser ou de l’art sonore.

En 2013, j’ai participé à un projet de recherche en art sonore à Mexico City, organisé par le directeur du label NAAFI. Nous devions travailler avec les archives de la Fonoteca Nacional, sampler et réinterpréter les archives. J’ai alors exploré les travaux des pionniers de la musique électronique au Mexique, comme Antonio Russek, Hector Quintanar, et d’autres. Cela m’a intéressé de mettre au jour tout cet héritage de la musique électronique et expérimentale de l’Amérique Latine.

Quel était le thème de votre performance à Ars Electronica ?

Neltokoni in Cuícatl, ma performance cette année à Ars Electronica, est un travail plus récent. Elle a été conçue avec une nouvelle équipe. C’est à propos des systèmes génératifs d’IA et des réseaux neuronaux. Cela fait partie du projet autour de mon album Transfiguracion, qui est sorti en mai dernier. J’ai travaillé avec de la synthèse audio brute. Certains systèmes d’IA fonctionnent avec du MIDI, mais ils sont par conception contraints à 12 tons, ils se conforment donc à une épistémologie spécifique du son. Je préfère travailler avec la synthèse audio brute, qui n’est pas autant limitée.

Ce qui m’intéresse, c’est de révéler de quoi sont capables ces technologies pour produire de la musique, ce que sont leurs spécificités, ce qui se produit uniquement quand on utilise ces systèmes. Les ratés de l’algorithme, les glitches sont une partie très importante, en tant que pratique conceptuelle. Cela contredit l’idée de perfection des systèmes d’IA, dont certains affirment qu’ils peuvent produire un son parfait qui correspond exactement aux besoins, comme c’est toujours le cas avec les nouvelles technologies. Quand sont sortis les synthétiseurs ou la MPC, par exemple, tout le monde essayait de répliquer les styles musicaux existants, mais ensuite de nouvelles sortes de musique sont apparues, aussitôt que les gens ont commencé à détourner ces technologies, à les utiliser d’une manière qui n’était pas prévue. C’est aussi ce qui me guide dans ma pratique des instruments, de l’électronique ou des installations. L’approche hacking dans la production de musique m’intéresse beaucoup.

Dans cette performance, j’ai utilisé un système d’IA qui effectue ce qu’on appelle un « transfert de style » – il modifie les styles de la musique, en faisant un morphing d’un style à un autre. J’ai utilisé l’album de 1980 « Templo Mayor » d’Antonio Zepeda comme source audio. C’était déjà un album de musique expérimentale. Je voulais entendre ce que ferait le système d’IA de ces sons pré-hispaniques morphés avec mon propre corpus musical de ces cinq dernières années ; non pas dans une perspective de pureté, mais avec l’idée de créer une filiation, un continuum. Les traces historiques de l’utilisation des sons et des instruments pré-hispaniques se sont perdues dans le temps, dans le processus de la colonisation. C’est donc une tentative pour créer un pont entre les anciennes manières de faire de la musique et la musique électronique contemporaine.

L’implication générale de tout cela, est de décoloniser l’Intelligence Artificielle. Cette technologie embarque tellement de biais. Lorsque vous travaillez avec, vous voyez de quoi elle est faite. On pourrait presque l’appeler Stupidité Artificielle. Ces technologies ne sont ni plus ni moins bonnes que les données que vous mettez dedans, et elles ont les biais des personnes qui les ont conçues. Donc, j’essaie de démystifier ces idées selon lesquelles l’IA serait quelque chose qui pourrait sauver l’humanité, ou créer une sorte de protection pour tout le monde. En utilisant les IA pour leurs possibilités génératives de son, il est intéressant de constater qu’elles ont été conçues avec la musique occidentale à l’esprit, et voir ce qui arrive quand on les glitche, quand on y crée une panique inattendue.

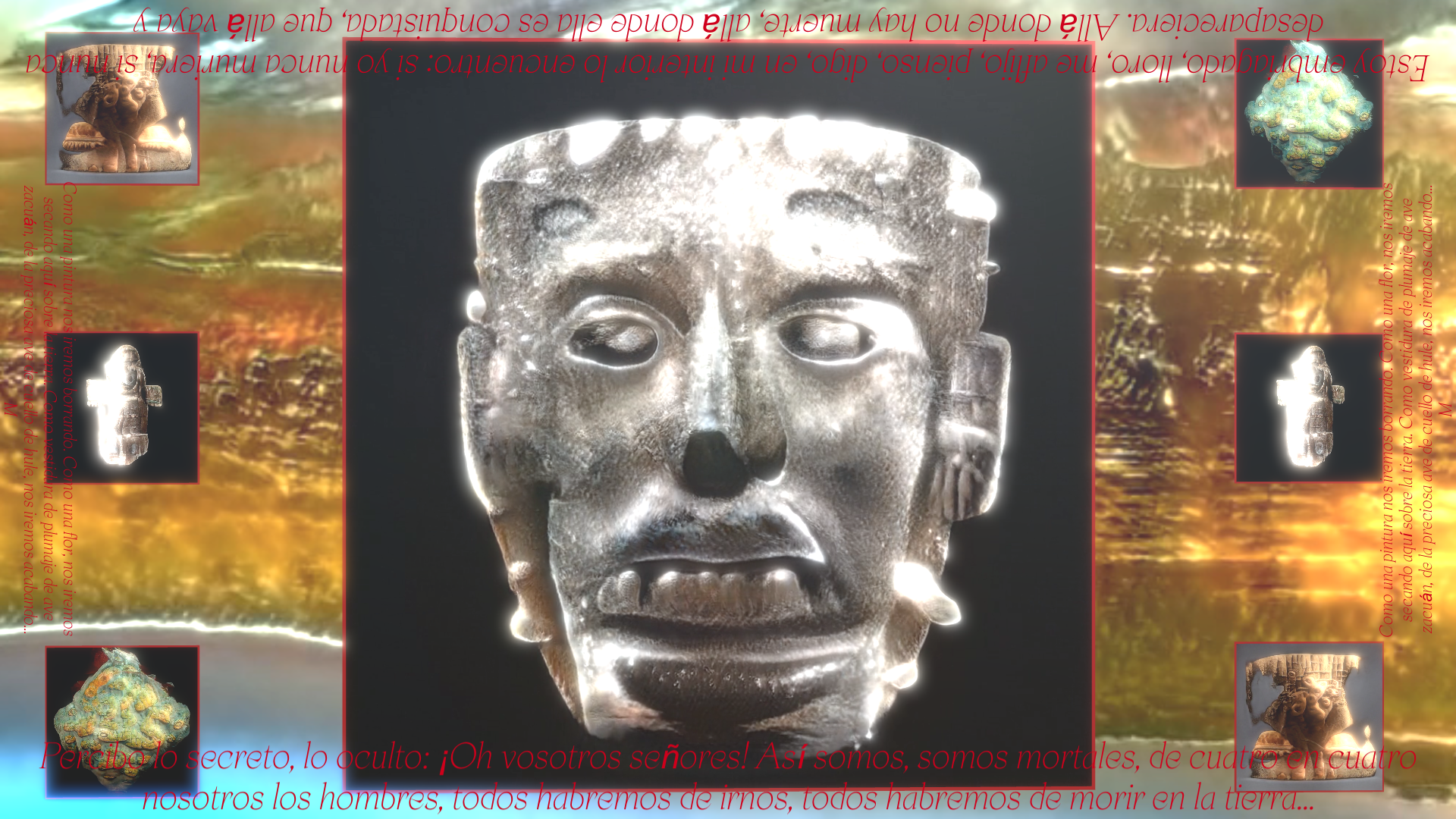

La performance pour Ars electronica, Neltokoni in Cuícatl, utilise trois systèmes génératifs d’IA. L’un utilise le modèle GPT-2 pour la génération de texte. Je l’ai entrainé avec de la poésie en Nahuatl ancien, une langue largement utilisée au Mexique à la période pré-hispanique, mais qui est toujours vivante. Ce modèle peut être entrainé avec n’importe quelle langue, même non-alphabétique, comme des icônes ou des emojis. En se basant sur les données, il y cherche des motifs récurrents, et essaye de prédire la lettre, ou le mot qui va suivre. Initialement, le modèle a été entrainé en Anglais bien sur. Il n’y a pas beaucoup d’ensembles de données en Nahuatl, ce qui soulève une autre question intéressante : Comment allons-nous amener ces épistémologies dans le futur lointain ?

Pour les images, j’ai principalement scanné Instagram à la recherche d’artefacts et de talismans mésoaméricains. J’ai trouvé cela intéressant, car c’était se réapproprier des images d’une plateforme de surveillance capitaliste (Facebook), pour leur donner une nouvelle vie. C’est une manière de résister : reprendre ces artefacts et les ressusciter dans une performance. Le sens métaphorique de la performance est que ces artefacts, ces talismans – « Neltokoni » veut dite « talisman » en Nahuatl et « in Cuícatl » signifie « dans la poésie » – parlent, sous forme de chanson, du procédé selon lequel ils ont été objectivés et ont été présentés en Occident. Le dernier objet qui parle dans la performance est la coiffe de Moctezuma, qui se trouve, comme par hasard, en Autriche, à Vienne précisément. Ces artefacts parlent du processus colonial, et je le vois comme un acte subversif, parce qu’ils sont à nouveau vivants par la culture et la connaissance, et non morts et exposés dans un musée. Une expression en Nahuatl dit « in Xochitl, in Cuícatl », qui signifie « dans les fleurs, et dans la chanson ». C’est une manière de leur faire raconter une histoire, dans un sens métaphorique, de les faire parler. Au cours de la performance, le visuel conduit le son, donc les images parlent par elles-mêmes, elles sont transfigurées en son. C’est une approche visuelle du son.

Les visuels sont génératifs eux-mêmes, ils sont générés par un modèle appelé StyleGAN2, développé par NVIDIA. Après avoir entraîné le modèle avec un millier d’images, il a créé un « espace latent », capable de synthétiser et de morpher entre les images via des motifs qu’il a identifié dans l’ensemble de données. Dans la performance, ce morphing est la composition musicale elle-même.

Je vois les IA comme un nouvel outil pouvant amener de nouvelles compétences. Par exemple, je ne suis pas un très bon artiste visuel, l’IA m’a aidé à créer un nouveau matériau visuel. En fait, les systèmes comme GPT-2 ou StyleGAN sont des intelligences artificielles très étroites, elles sont très fortes pour des tâches spécifiques, au contraire de cette idée d’IA qui soi-disant pourrait tout faire. Je suis très dubitatif sur le fait que cela puisse un jour exister. Ces technologies sont artificiellement stupides, parce qu’elles ne peuvent faire qu’une seule chose à la fois.

Dans leur livre Nooscope, Vladan Joler et Matteo Pasquinelli démystifient la technologie de l’IA ; j’aime beaucoup la façon dont ils le font. Ils font une belle comparaison : les IA sont à l’esprit et à l’information, ce que les microscopes et les télescopes sont à l’œil ; c’est-à-dire des outils qui ouvrent sur des mondes et des modes de perception nouveaux. Par exemple, l’IA réduit le temps humain, en analysant ces données – en y cherchant ce que nous n’avons pas le temps d’y voir, parce que c’est trop de données. C’est voir ces technologies de manière banale, parce qu’elles sont stupides, elles ne suggèrent rien, elles sont juste très bonnes pour chercher des motifs dans des énormes quantité de données. Elles créent une espèce de boucle de feedback : vous obtenez un résultat, vous pouvez travailler dessus, et le ré-injecter dans le système.

Vous vous êtes aussi intéressé aux deep fakes ?

J’ai travaillé avec l’algorithme Wav2Lip. Il fait du lip-syncing (synchronisation des mouvements de la bouche – ndlr). Tu lui donnes une vidéo d’une personne qui parle ou autre, puis une piste audio, de préférence une voix qui parle, et automatiquement tu obtiens la vidéo de cette personne synchronisée avec ton audio. L’algorithme a été créé au départ pour le doublage de films. Evidemment tu peux faire des choses amusantes avec ça, mais aussi des trucs malveillants. Pour moi, dans le contexte de l’Amérique Latine et du Sud Global, il s’agit plus de faire savoir aux gens que ces technologies existent et qu’elles sont très accessibles. J’ai travaillé sur un projet de deep fake, avec une approche critique de cette technologie, une approche pédagogique. J’ai fait cette vidéo sur les deep fakes, et les gens sont venus me dire : « Ah OK, donc tu n’as pas besoin d’être un super réalisateur vidéo, tu appuies sur un bouton, et tout de suite c’est très convaincant ». C’est un peu éducatif, mais je l’ai rendu aussi un peu amusant… Nous voyons que cette technologie est de plus en plus utilisée par les trolls d’extrême-droite. Cela a commencé avec le porno, pour remplacer les visages sur les vidéos porno. Donc il faut sortir cette technologie de cette scène très machiste. J’ai aussi travaillé avec des technologies de clonage de voix, et la combinaison de ces deux techniques peut potentiellement faire de gros dégâts. Cela peut sembler vraiment « réel », surtout si tu ne sais pas que ces technologies existent.

Je veux avoir une approche différente, plus drôle et plus ludique. J’aime l’idée de média synthétique, qui est le terme juste pour parler de tous les résultats génératifs produits par des IA. Il y aura un moment dans l’Histoire où tout ce ce que nous verrons sur Internet, nous ne serons plus capables de dire si cela a été produit par une personne ou par une IA. C’est le réel danger. Il existe déjà une chaîne où l’on peut voir deux petits robots qui conversent ensemble, qui se répondent en utilisant uniquement GPT-2. C’est effrayant, mais aussi drôle et inoffensif. Avec ces systèmes, on peut créer d’énormes quantités de données, et bientôt personne ne pourra dire si c’est réel ou non.

C’est ce qui m’intéresse en ce moment, soulever des questions au sujet de ces technologies. Je ne m’adresse pas particulièrement à la communauté artistique, parce que je sais que les artistes sont souvent au courant de ces sujets. Je préfère atteindre des gens qui ne sont peut-être pas familiers de ces technologies, m’adresser à un plus large public.

View this post on Instagram@hexorcismos el amlo que queremos pero nunca vamos a tener #fuckthepolice #acab

A post shared by ? (@mexicoissocheap) on

Quels sont vos projets à venir ?

Je participe au festival Transart en Italie la semaine prochaine, je vais y jouer mon album Transfiguracion. J’ai aussi un projet en cours de développement, intitulé The New Pavlovian Bells, dans lequel je veux explorer les effets des notifications de Facebook, Twitter, etc. Toutes ces plateformes ont été conçues selon des principes issus de la psychologie comportementale. Dans les expériences de Pavlov, quand le chien entend la cloche, il commence à saliver. Aujourd’hui, nous entendons en permanence ces sons de notifications qui nous engagent à faire quelque chose. Je veux explorer un peu ce que cela produit sur nos cerveaux, nos émotions et notre santé mentale. Je conduis aussi des ateliers d’introduction au machine-learning pour les musiciens, les artistes sonores et le grand public. Les prochaines sessions auront lieu fin octobre / début novembre.

Suivre Moisés Horta sur : son site, Instagram, Twitter

Ecouter Hexorcismos sur Bandcamp