Voitures autonomes vs hackers: la guerre a commencé

Publié le 10 avril 2017 par Nicolas Barrial

Des bus sans chauffeur à l’essai à Lyon, Paris ou Londres, des voitures qui se garent toutes seules… Si le véhicule autonome roule déjà, les hackers sont en embuscade pour dénoncer ses failles de sécurité.

Progressivement, l’idée de confier notre vie à des véhicules sans chauffeur trace sa route. Les tests de bus sans chauffeur se multiplient, à Lyon, Paris ou encore Londres. Une étude publiée en janvier 2016 prévoit qu’en 2030, 15% des voitures vendues dans le monde pourraient être autonomes.

Le 14 mars 2017, une vidéo postée sur Vimeo montrait une voiture autonome immobilisée par une ligne blanche continue tracée au sol : Autonomous Trap 001 est un piège imaginé par James Bridle comme un rituel de désenvoûtement. L’artiste hacktiviste britannique travaille aussi sur un sytème DiY pour véhicule autonome qu’il partage sur Github.

«Autonomous Trap 001», James Bridle, 2017:

A l’origine de cet engouement, Google, qui depuis 2009 travaille sur la voiture autonome via sa filiale Waymo – dont Uber est accusé d’avoir copié les solutions pour équiper sa future flotte sans chauffeur. L’industrie automobile n’est pas en reste. Le point commun de la majorité des projets de véhicule sans chauffeur, c’est l’utilisation du balayage laser Lidar (Light Detection and Ranging) qui permet de détecter les obstacles. Une solution à 80000€ l’unité, dont le leader mondial est l’Américain Velodyne.

Elon Musk boude le Lidar

La seule voix discordante est celle d’Elon Musk, président de l’usine de véhicules électriques Tesla, qui trouve le Lidar trop cher. Et même si Quanergy, une start-up californienne, promet un Lidar à 250$, Elon Musk préfère miser sur le traitement performant des données transmises par le combo caméras, radars et ultrasons qui équipe déjà ses véhicules. Un pilotage automatique que les clients Tesla laissent parfois enclenché sur des centaines de kilomètres et qui a déjà fait une première victime.

Le pilotage automatique d’un modèle Tesla X évite un accident:

@elonmusk Finally the right one. pic.twitter.com/2fspGMUoWf

— Hans Noordsij (@HansNoordsij) December 27, 2016

Un Raspberry Pi se paye le Lidar

En matière d’accidentologie, les véhicules autonomes devraient toutefois faire mieux que les conducteurs humains, mais leurs systèmes de guidage ne sont pas totalement à l’abri. En septembre 2015, Jonathan Petit, chercheur français chez Security Innovation, affirmait avoir trompé un Lidar à l’aide d’un petit ordinateur Raspberry Pi. Le chercheur a profité des données non sécurisées recueillies par le laser pour simuler un obstacle qui a paralysé le véhicule.

Pas mieux du côté de Tesla qui a dû lancer une mise à jour de sécurité pour son pilote automatique en 2016, après que des ingénieurs chinois ont pris le contrôle d’une Tesla S à 20km de distance. Merci Internet.

Les ingénieurs chinois de Keen Security racontent l’attaque sur la Tesla S (en anglais):

De l’éthique dans le moteur

Même proprement sécurisé, le système de guidage est à égalité avec le genre humain si un piéton décide de traverser sans regarder. A l’image des drones, des questions d’éthique s’invitent dans le débat : un véhicule autonome doit-il éviter le piéton au risque de tuer ses occupants ? Et la réponse sera-t-elle la même si elle vient du constructeur, de l’assureur ou de l’humanité ? A ce titre, le MIT propose depuis 2016 d’alimenter une base statistique en se soumettant à un questionnaire de mise en situation appelé Moral Machine.

Présentation de l’initiative Moral Machine du MIT (en anglais):

Le piéton, ce hacker comportemental

Le piéton n’a pas fini d’être un clou dans le pneu de la voiture autonome. En cause, un article publié en octobre 2016 par Adam Millard-Ball. Ce chercheur à l’université Santa Cruz de Californie y développe une théorie basée sur « the chicken game », un jeu de trompe-la-mort qui consiste à placer son véhicule à contresens et à attendre afin de savoir quel véhicule craquera le premier pour éviter l’accident. A l’évidence, une voiture autonome s’écarterait systématiquement. Le chercheur imagine les piétons développer un comportement d’impunité vis-à-vis des véhicules autonomes, les forçant à des freinages intempestifs. Un impact potentiellement dangereux et qui pourrait remettre en cause l’amélioration du trafic promise par les voitures sans conducteur.

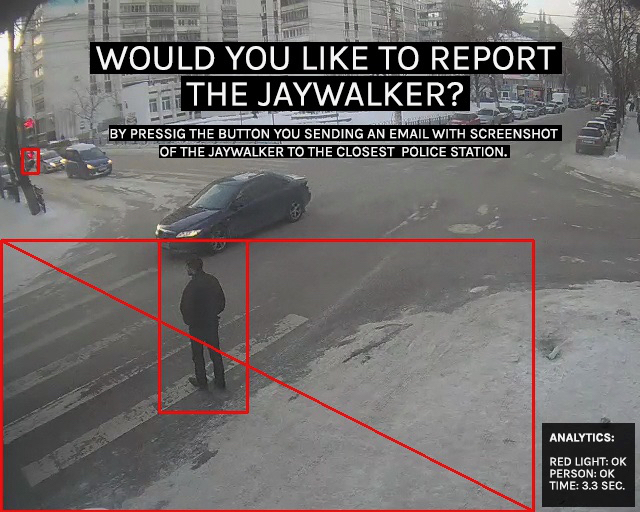

Cette étude ne devrait pas peser lourd face aux investissements du secteur. De là à développer des systèmes pour mettre les piétons au pas… Cette possibilité a été envisagée par l’artiste belge Dries Depoorter et son installation Jaywalking, présentée en 2015 au festival du documentaire IDFA à Amsterdam. Tandis qu’une intelligence artificielle pointait ceux qui ne traversaient pas dans les clous (jaywalkers en anglais) sur les images d’une caméra de surveillance, les visiteurs avaient le choix de les dénoncer à la police. Au moins la machine nous laisse-t-elle le plaisir masochiste de nous punir entre nous.